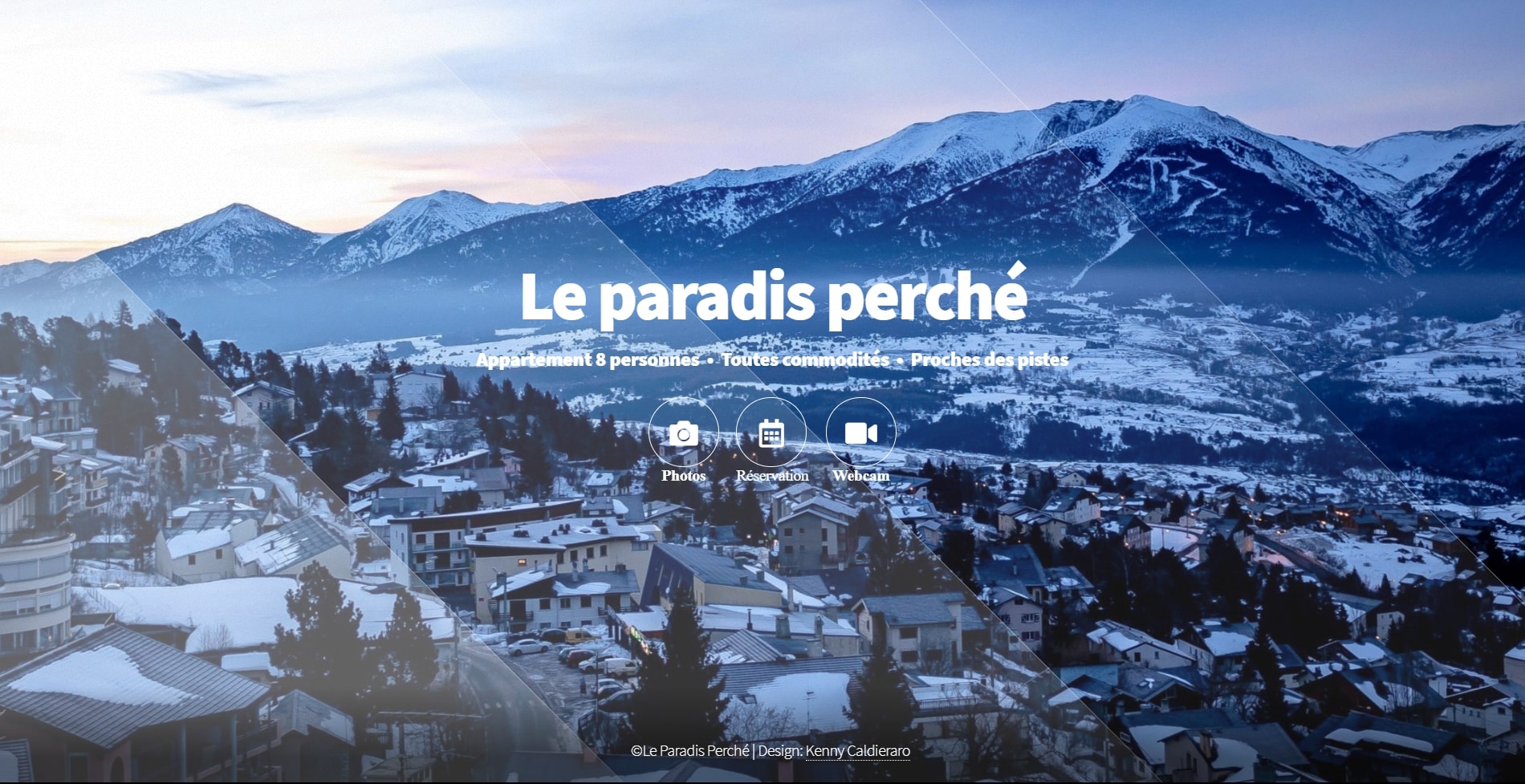

Site de présentation, gestion locative, et réservation gite

Les députés doivent examiner, début mars, un projet de loi relatif aux Jeux olympiques et paralympiques de 2024, qui, parmi d’autres mesures, autorisera, à titre expérimental, l’utilisation de la vidéosurveillance automatisée pour la sécurité de manifestations sportives, récréatives ou culturelles.

Passons sur le fait, déjà largement commenté, que le texte s’appliquera bien avant – dès que la loi sera adoptée, notamment lors de la Coupe du monde de rugby – et encore bien après les JO, puisque l’expérimentation prendra fin quasiment un an après, le 30 juin 2025…

Passons encore sur le mode expérimental si souvent prisé par le gouvernement en matière de sécurité, qui consiste à afficher une posture de prudence à l’égard de l’utilisation d’une nouvelle technologie, mais qui ne donnera lieu à aucune évaluation indépendante… Une fois que le dispositif aura été pris en main par les autorités publiques, il sera difficile de revenir en arrière. Au-delà de son maintien, gageons de surcroît qu’il sera tôt ou tard étendu à tout l’espace public.

Passons enfin sur le doute que le texte entretient sur la portée de ces systèmes de surveillance automatisée, puisque c’est un décret qui précisera le type d’événement qu’ils seront appelés à détecter. Doute encore renforcé lorsque l’étude d’impact qui accompagne le projet de loi laisse entendre qu’à côté du repérage des objets abandonnés et des mouvements de foule seront également visés les « événements anormaux » et les « situations présumant la commission d’infractions ».

Ce faisant, en traitant des caractéristiques comportementales d’individus identifiables après coup – en cas d’interpellation, par exemple, ces systèmes lorgneraient, d’après certains juristes, du côté des données biométriques, ce que le projet de loi prétend pourtant ne pas faire. Pour rappel, la réglementation européenne prévoit un régime d’encadrement très strict du traitement de ces données sensibles.

Arrêtons-nous plutôt un instant sur l’un des arguments avancés par le gouvernement pour rassurer le législateur et la population : les logiciels qui équiperont les caméras ne feront que « signaler » un comportement suspect aux agents en charge de visionner les vidéos. Il ne s’agirait donc que d’un outil destiné à assister ces derniers, à l’heure actuelle dans l’incapacité de réaliser cette détection, face au trop-plein d’images qui parviennent aux centres de visionnage.

On nous vend donc l’efficacité et la neutralité d’un outil informatique, tout en insistant sur l’intervention humaine en bout de chaîne : ce n’est pas la machine qui décidera in fine de l’attention et des suites à accorder au signalement. La réalité du processus, de l’élaboration de l’outil jusqu’à son utilisation, a pourtant de quoi susciter des inquiétudes légitimes.

Il vous reste 54.64% de cet article à lire. La suite est réservée aux abonnés.

Aucun commentaire n'a été posté pour l'instant.